深度丨 DeepSeek入局金融AI,一名“理科优等生”的上岗路

- 国际

- 2025-02-13 23:42:05

- 24

21世纪经济报道记者李览青 上海报道

经过两年多的探索,金融行业已经达成的共识是,大模型基于巨量数据语料学习实现快问快答的“快思考”,仍不能满足产业应用侧的实际业务需求,侧重推理逻辑的“慢思考”必不可少。

去年9月,OpenAI-o1模型一经推出就在全球AI市场掀起风暴,正是因为其通过强化学习和思维链拆解了复杂问题,使大模型的推理能力得到大幅提高,特别是解决数理问题和复杂任务的表现显著优于GPT系列的通用大模型。

然而,o1模型推理能力的提升是以响应速度与算力消耗为代价的。与GPT系列通用大模型的“秒答”相比,o1的响应速度大约需要10秒,且使用价格高昂。

在这个春节前,DeepSeek正式发布DeepSeek-R1推理大模型,并同步开源模型权重,成为全球第一个成功复现o1能力的模型,在推理性能与o1持平的同时,将相关算力消耗降到十分之一。通过官方API接入R1模型的输入token(命中缓存)价格只有o1的五十分之一,未命中缓存以及输出token的价格大约是二十七分之一。

谈到R1带来的这场技术热潮,一家股份行数字化转型部门高层难掩激动,向记者表示:“毫不夸张的说,DeepSeek研发出了目前国内开闭源模型中性价比最高的大模型。”他指出,这里的性价比既包括推理成本上的节约,也有业务场景应用能力的大幅跃升。“过去很多上报申请资金的AI项目,或由于成本高昂,或是落地计划不够实际,最终没能过批,但现在我相信未来会有大量创新项目涌现。”

多位受访对象指出,R1模型通过开源实现了“AI平权”,能释放更多中小金融机构的AI应用想象力,形成更多确定性的应用,但这样的优等生要真正“上岗”,依然离不开传统通用大模型在落地时的语料训练、算法调优与算力加持。

另一个需要明确的是,多家金融机构宣布接入了DeepSeek-V3和R1全尺寸模型,不意味着其他通用模型厂商的败退。在下一个技术“奇点”出现前,通用大模型、深度推理大模型、多模态模型以及核心业务场景下的小模型仍将处于并存状态,根据不同场景实施应用落地。

补齐短板:一个“全科211硕士”的诞生

“嗯,用户的问题是……”

这是DeepSeek在很多时候回复用户的第一句话。当你向DeepSeek提出一个问题,它会通过十几秒的深度思考后再给出回复,并在回复中提到自己如何理解这一问题、该问题涉及哪些方面、用户可能期待哪些方向的回复,这就是深度推理大模型的“慢思考”过程。

R1模型的慢思考能力来自于DeepSeek的算法创新。相较于传统大模型的“秒问秒答”,R1不会提供直接响应,而是对指令内容进行多次推理,采用思维链、共识和检索来生成最佳答案。由于模型每一次生成内容都需要反复思考,因此也会创建出更多的输出标记,从而进一步提高模型质量。

在多位受访对象看来,R1带来最大的变化是补齐了传统通用大模型的推理短板。

“整体来看,现在的大模型拥有全科211硕士的能力。”一位来自腰部券商的信息技术负责人向记者表示,一个具备完整能力的数字员工,需要兼具快思考和慢思考两种能力,在R1的加持下,“慢思考”得以实现。

他坦言,在DeepSeek开源R1之前,机构要应用深度推理模型只能选择接入o1模型的API接口,但金融行业出于合规和数据安全考量,不可能在生产环节实际应用,如今R1的出现可以分析复杂数据并通过思维链模拟人类的推理思维过程,性能与o1不相上下。

一家城商行大模型业务负责人也告诉记者:“之前我们接入的都是类似通义千问、DeepSeek-V3这样的通用大模型,始终没有像o1这样的深度推理大模型,R1模型发布后AI应用才真正有了深度思考的能力。”

以智能营销场景为例,传统通用大模型生成的营销话术,或是基于规则系统对语料的组织整合,亦或是基于用户给出的指令进行快速反馈,但如果受到指令方的质疑,可能无法通过多次交互达到营销效果,但基于推理大模型的深度理解,与用户的交互将更加智能准确。

算力、数据:通用大模型走过的路一条也不能少

虽然R1模型是精于推理的“优等生”,但要成为金融行业从业者,和传统通用大模型在金融行业要经受的考验是一样的。

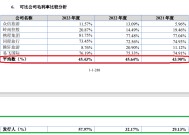

AI行业权威的Vectara HHEM人工智能幻觉测试显示,DeepSeek-R1显示出14.3%的幻觉率,远高于同为DeepSeek旗下V3模型3.9%的幻觉率,也超过了行业平均水平。

“学而不思则罔,思而不学则殆。”这句话在AI领域同样适用。

R1模型的超强推理能力使得它在数理能力和逻辑推理方面表现优秀,但在文科内容输出方面“过度发挥”从而产生幻觉。

一家金融机构的首席信息官告诉记者,他在尝试通过DeepSeek生成个人简历时发现,其表述出现“胡说八道”的情况,但其他通用大模型基于公开资料梳理较为准确。

前述城商行人士向记者坦言,在逻辑推理能力方面,R1模型的表现是目前国内大模型中最突出的,但在本地化部署输入金融相关语料数据前,其专业知识理解依然存在偏差。

“灌进去的知识也不是立刻就能用得上它的逻辑思维能力。”他表示,所有大模型在金融行业的落地,都需要解决算力和数据这两大问题。

一方面,AI战略下语料需求带来的数据治理仍是金融机构的必答题,R1模型更大的幻觉问题对高质量数据集和知识库提出更高的要求。

另一方面,在算力角度,记者了解到,金融机构如果要本地部署大模型,其算力消耗包括两个方面,一是本地部署激活所需的算力成本,二是推理过程中消耗的算力成本,前者是固定的成本支出,根据部署模型的不同尺寸会有所差异,后者则是关乎模型效果的成本支出。

不过与通用大模型相比,R1模型无论是在推理成本还是训练成本上都有显著优势,降低了算力端的落地应用成本。

值得一提的是,虽然多家金融机构都官宣接入DeepSeek-R1或V3相关模型,但各家金融机构根据自身资源禀赋不同,或是成本支出、实际应用等方面的考量,接入模型的尺寸是有差异的。

例如邮储银行、江苏银行接入的是轻量版DeepSeek-R1模型,另有一家大行金融科技部人士告诉记者,该行目前刚刚部署了14B的R1模型还在测试中。而前述腰部券商IT部门则是部署了R1的全尺寸模型。

前述城商行人士向记者表示,DeepSeek-R1模型有7B、14B、32B、671B等不同尺寸模型供用户选择,用户基于个人或企业需求可自行部署,小尺寸模型是基于“满血版”671B模型的蒸馏版,其性能和效果都会存在差异。但通义千问旗下Qwen2.5开源版本的最大尺寸是72B。

这意味着如果金融机构想要通过本地化部署实现最佳效果,“满血版”R1模型的本地化部署所需的显存远高于Qwen2.5,这或许也是一些机构从轻量模型开始试水的一大原因。

变革已至:释放创新应用想象力

尽管不同金融机构接入DeepSeek的深度有所差异,但对于金融行业来说,R1强大的推理能力仍将释放创新应用的想象力,带来一场AI应用的深度变革。

其实金融行业对DeepSeek也不陌生。记者了解到,早在一年多以前金融机构尝试AI大模型部署应用时,就接入了DeepSeek-Coder-V2开源代码语言模型。在接受21世纪经济报道记者采访的7家金融机构IT部门人士中,有5家机构的智能代码助手模型是基于Coder-V2提供服务的。

“我们尝试过市面上大部分代码语言模型,可能因为幻方量化本身在量化编程方面的能力就很强,Coder-V2在代码生成方面的能力会更好。”有受访对象表示。

“DeepSeek通过开源R1模型实现了‘AI平权’。”前述券商人士表示,原本这类推理模型需要超强的技术背景,如深度学习、神经网络推理、元学习等,但DeepSeek开放的技术报告,让所有机构得以在自己的大模型上复现用于构建R1模型的强化学习工作流,以知识蒸馏方式实现从DeepSeek到金融垂域大模型的能力转移,从而实现AI应用在复杂金融场景中的实战效能。

他表示,在证券领域,将为行业探索“AI+经纪”、“AI+投研”、“AI+投顾”、“AI+合规”、“AI+文档”等创新模式开辟新路径、新场景。同时,他所在公司计划基于深度推理大模型进一步增强AI诊股、AI涨停分析、行研报告生成等AI功能。

值得关注的是,推理大模型的出现并不意味着通用大模型的撤退。如今,通用大模型、推理大模型、多模态模型和小模型正在不同金融业务场景发挥着各自的作用。

“对于我们这样将AI作为核心战略的银行来说,DeepSeek将加速创新应用的出现,而对部分此前出于成本考量而没有大规模实施AI战略的中小金融机构来说,或许会重构其科技规划。”一位银行数字化转型部门高层向记者表示,虽然AI在金融核心业务场景的落地实施还存在痛点,但人工智能的目标并不是代替业务人员做到100%的准确,而是通过人工智能来提供金融服务的更多可能,在业务上产生更大的创新应用价值。

“如果一家银行的CIO对AI抱有这种不切实际的期望,或许是不理解智能时代AI的真正价值。”他表示。

上一篇:交易火爆!国有大行提示风险

有话要说...